目次

はじめに

てくますプロジェクトでは、てくますゼミと呼ばれる輪読会を隔週で開催しています。

少人数であーだこーだ議論しながら、考える楽しさを分かち合う、ゼミのようなコミュニティです。主に、AIなどの「IT × 数学」領域について学習しています。

現在は「ゼロから作るDeep Learning」というディープラーニングの有名な本を読み進めています。

今回は本書第3回の輪読会ということで、4章を読み進めました!

本記事では、今回の勉強会で学んだことをざっくりと紹介していきます。

学習内容(4章)

ニューラルネットワークの学習

ニューラルネットワークの学習とは、訓練データから最適な重みパラメータを自動で獲得することを指します。

損失関数という指標を導入し、損失関数の値が最も小さくなる重みパラメータを探します。探し出すための手法として、勾配法と呼ばれる手法を用います。

損失関数

損失関数とは、ニューラルネットワークの学習で用いられる指標です。

損失関数の種類として、2乗和誤差や交差エントロピー誤差があります。

交差エントロピー誤差は2乗和誤差と比べると直感的な数式ではありません。しかし、損失関数としては交差エントロピー誤差関数の方が多く使われるらしいです。交差エントロピー誤差関数は勾配法と相性が良いためです。

交差エントロピー誤差については、下記の記事がわかりやすいので、ぜひ見てください。

【参考】交差エントロピー誤差をわかりやすく説明してみる(外部リンク)

なぜ直接の目的である正解率などではなく、損失関数を指標にしているのかというと、正解率などは不連続であり、勾配法と相性が悪いためです。

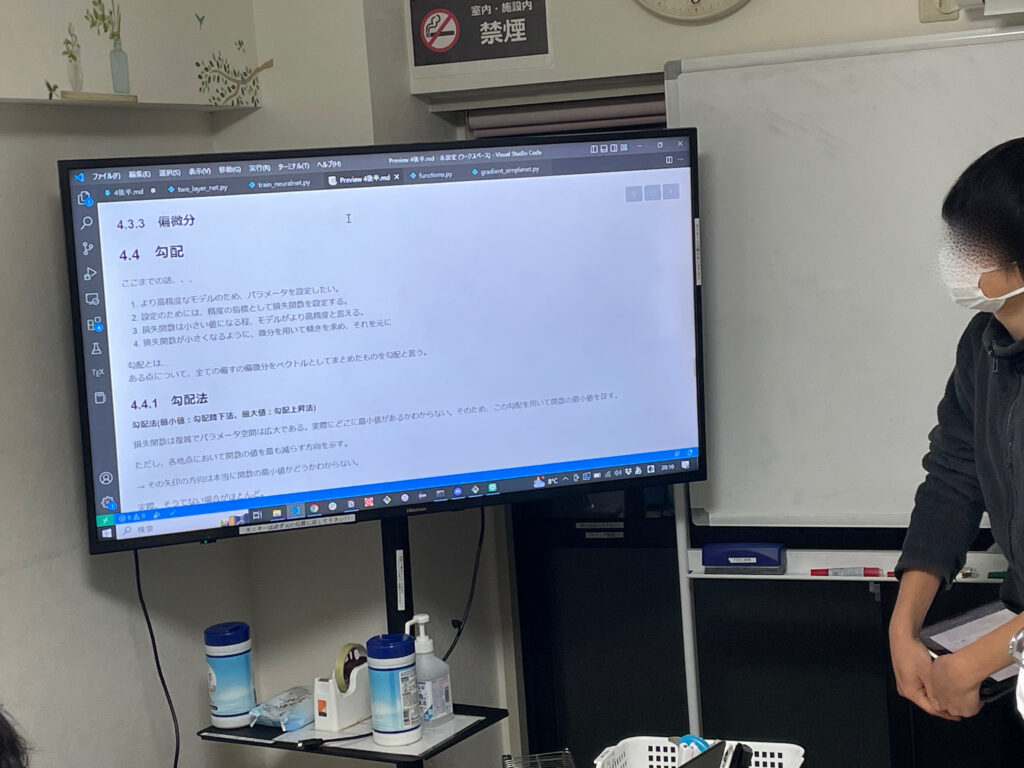

勾配法

損失関数の最小値を求めるには勾配法を用います。勾配法とは、グラフの今いる点の勾配(各重みパラメータによる偏微分係数を並べて出来るベクトル)に沿って下っていくことで、最小値を探す手法です。

勾配法については、下記の記事がわかりやすいので、ぜひ見てください。

【参考】勾配降下法とは?分かりやすく図解で解説(外部リンク)

本章では、数値微分を用いて勾配を計算しています。しかし数値微分には、計算に時間がかかるという難点があります。そこで次章では微分の計算の工夫として、誤差逆伝播法を学びます。

最後に

「ニューラルネットワークの学習」というメイントピックに入り、輪読会もますます面白くなってきました。私はこの内容について今回初めて学びましたが、その理論のシンプルさに驚いています。

次回は誤差逆伝播法です。この輪読会もやっと後半戦に。

では、また!