目次

はじめに

こんにちは。てくますプロジェクトのYukkinです!

この記事は、てくますプロジェクトが開催した輪読会「ゼロから作るDeep Learning」の活動記録です。

てくますプロジェクトは、「考える楽しさを探そう!」を合言葉に活動する、数学と情報科学の学習コミュニティです。各種イベントについては、ぜひ Connpass をご覧ください!

この輪読会は2023.01〜2023.03に開催しました。

本の紹介

リンク

ディープラーニングの超有名な本です。外部のライブラリに頼らず、ゼロからディープラーニングを作ることで、ディープラーニングの基本的なアイデアを学べます。とても分かりやすく面白い本です。

活動記録

第1回 パーセプトロン

2023/01/16に実施。

1章と2章を読み進め、以下の内容を学習しました。

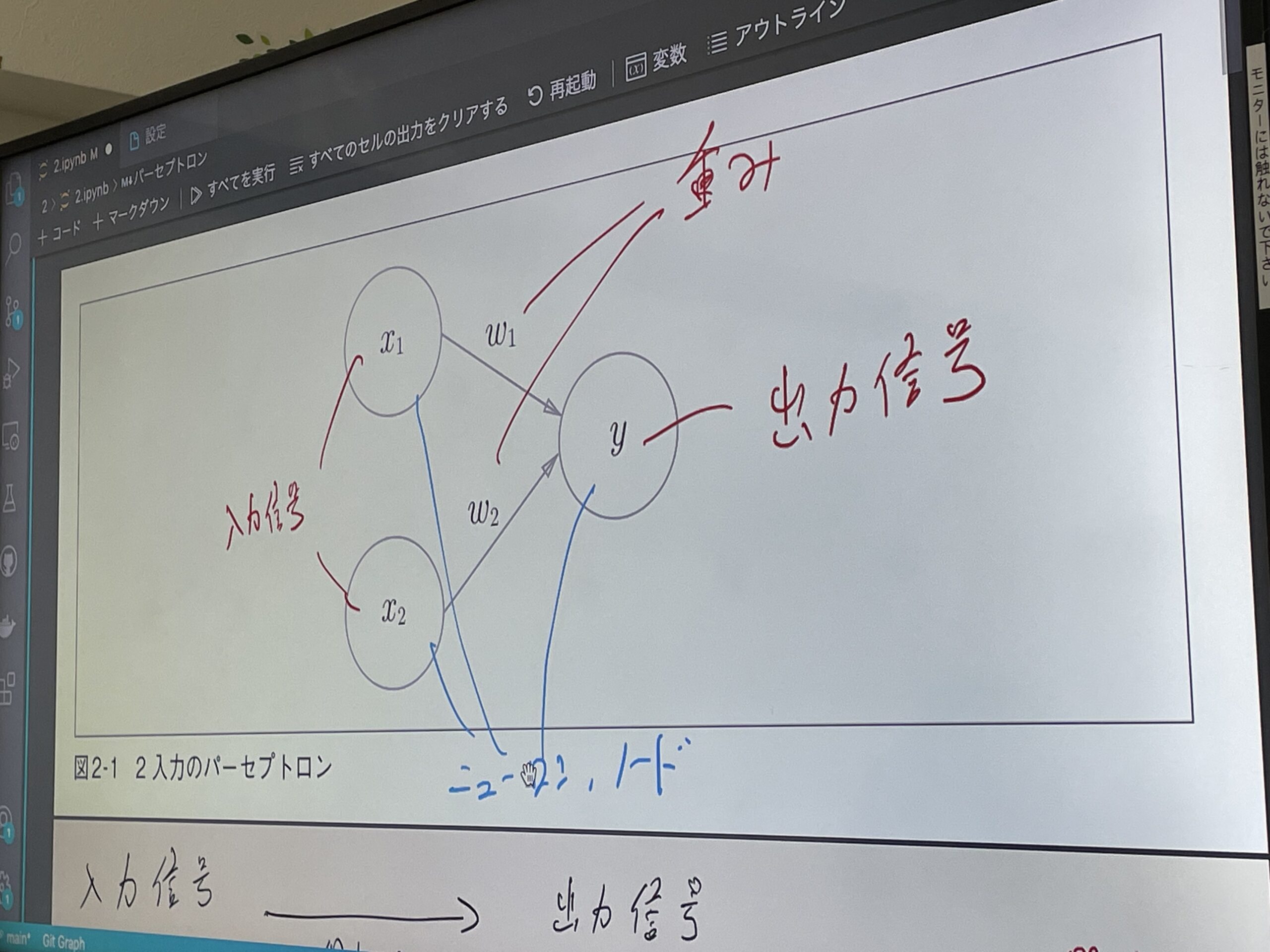

- パーセプトロン

ニューラルネットワークの最も基本的なモデルを学びました。

第2回 ニューラルネットワーク

2023/01/30に実施。

3章を読み進め、以下の内容を学習しました。

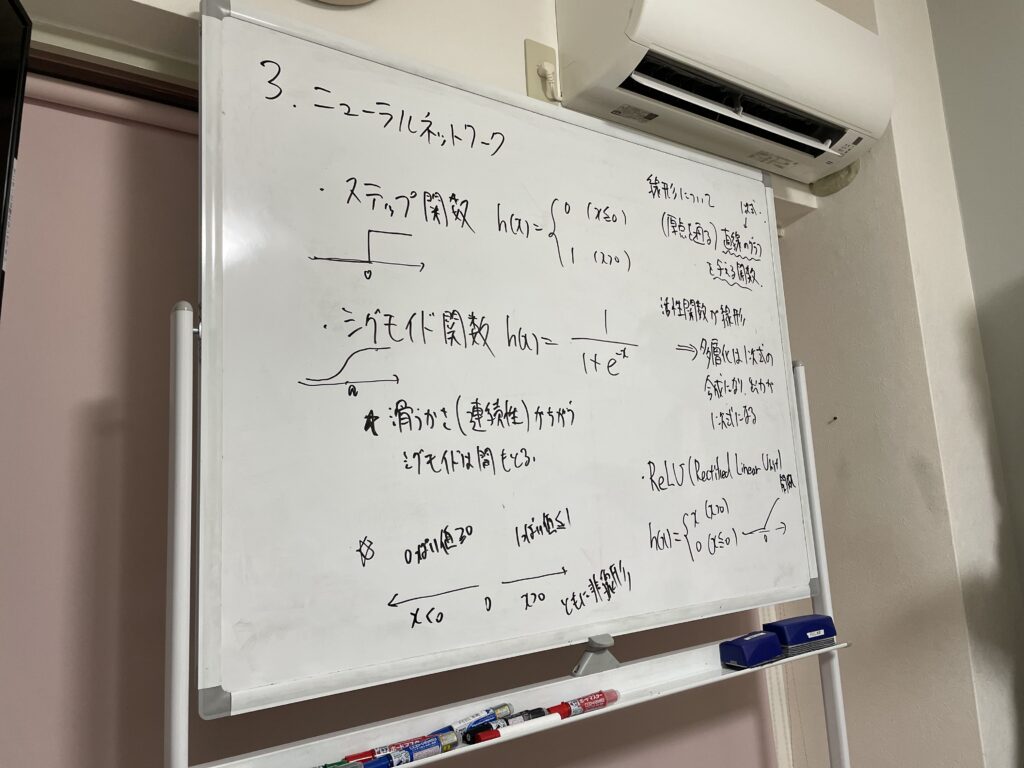

- ニューラルネットワーク

複数の層を重ねることで、線形モデルでは表現できないモデルが作れることを学びました。 - 活性化関数

非線形性を導入するために用いられる関数で、ニューラルネットワークの表現力を高める役割を学びました。

第3回 ニューラルネットワークの学習

2023/02/13に実施。

4章を読み進め、以下の内容を学習しました。

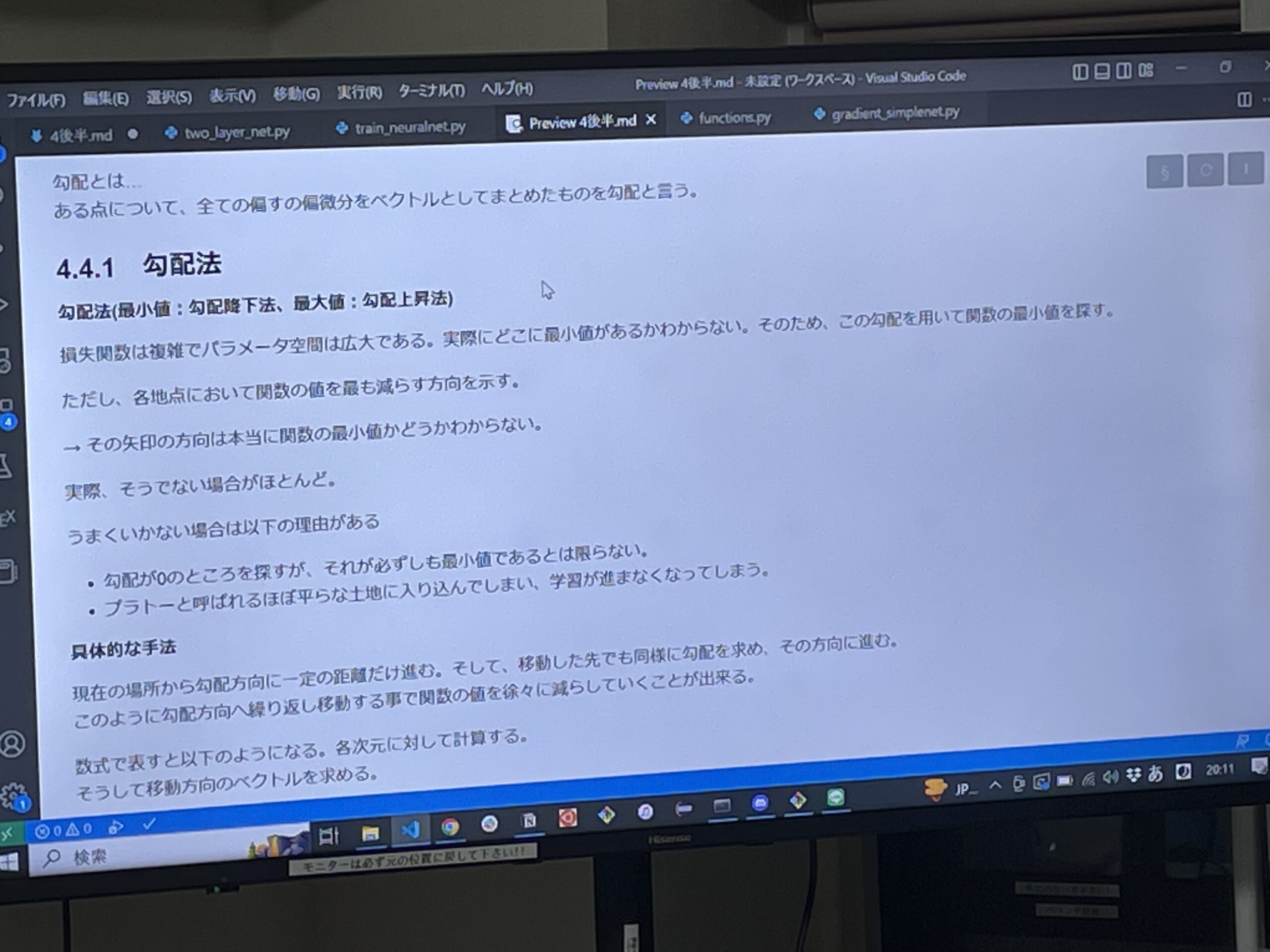

- 勾配法

勾配法を用いて損失関数の値を小さくすることで、ニューラルネットワークのパラメータを段階的に更新していく学習の仕組みを学びました。

第4回 誤差逆伝播法

2023/02/27に実施。

5章を読み進め、以下の内容を学習しました。

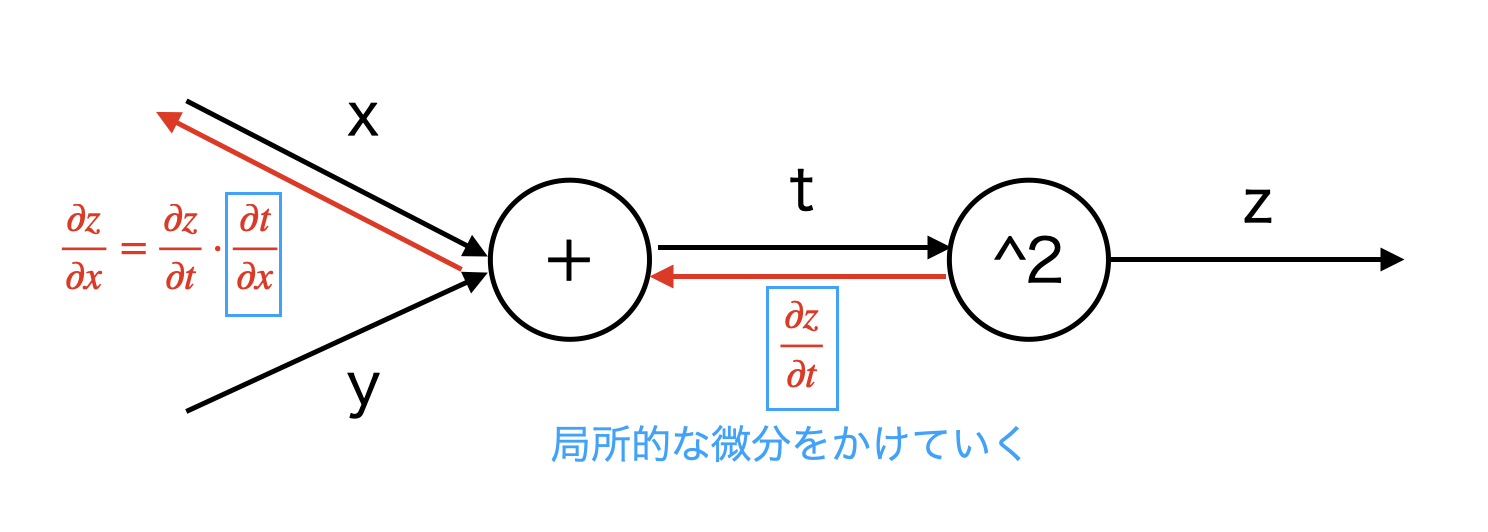

- 誤差逆伝播法

出力層から入力層へと誤差を伝播させ、効率的に勾配を計算する方法を学びました。

第5回 学習に関するテクニック

2023/03/13に実施。

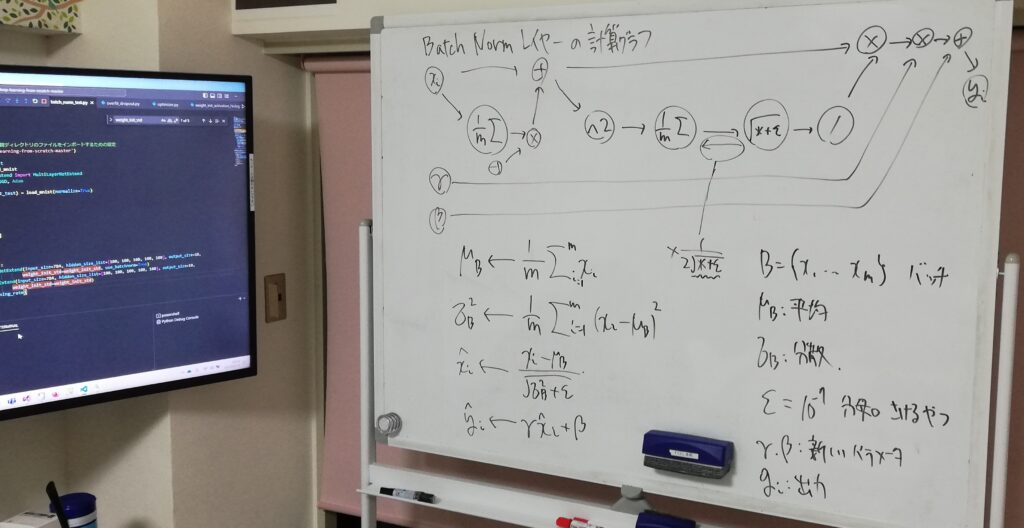

6章を読み進め、以下の内容を学習しました。

- パラメータの更新方法

SGD、Momentum、AdaGrad、Adamなどの最適化手法が存在することを学びました。 - 重みの初期値の工夫

学習をスムーズに進めるためには、重みの初期が重要であることを学びました。 - Batch Normalization

各層の出力を正規化することで、学習を安定させ高速化する手法を学びました。 - 過学習を抑える工夫

Drououtなどの正則化手法を学びました。

第6回 畳み込みニューラルネットワーク

2023/03/27に実施。

7章を読み進め、以下の内容を学習しました。

- 畳み込みニューラルネットワーク(CNN)

画像データの特徴を効率よく抽出するために設計されたニューラルネットワークを学びました。

おわりに

この本を通じて、ディープラーニングの理論をじっくり学ぶことができました。この本がとても面白かったので、次回はこの続編を読み進めていくことに決まりました。人数も6人くらいで安定してきて賑やかになってきました。

では、またね!

コメントを書く