目次

はじめに

こんにちは。てくますプロジェクトのYukkinです!

この記事は、てくますプロジェクトが開催した輪読会「BERTによる自然言語処理入門」の活動記録です。

てくますプロジェクトは、「考える楽しさを探そう!」を合言葉に活動する、数学と情報科学の学習コミュニティです。各種イベントについては、ぜひ Connpass をご覧ください!

この輪読会は2023.10〜2024.02に開催しました。

本の紹介

リンク

自然言語処理をさらに学ぶため、BERTの入門書に取り組みました。BERTで実際にさまざまなタスクを解いていく実践寄りの本です。

活動記録

第1回 自然言語処理

2023/10/30に実施。

1章と2章を読み進め、以下の内容を学習しました。

- BERT

BERTの概要を学習しました。BERTは2018年にGoogleが発表した自然言語処理モデルです。BERTは、自然言語処理の様々なタスクにおいて当時の最高スコアを叩き出しました。BERTには事前学習とファインチューニングの学習過程があることが特徴です。 - ニューラル言語モデル

言語モデルは文章の出現のしやすさを確率によってモデル化したものです。ゼロつく②で学んだ内容の復習にあたります。

第2回 BERTの基本的な使い方

2023/11/13に実施。

3章と4章を読み進め、以下の内容を学習しました。

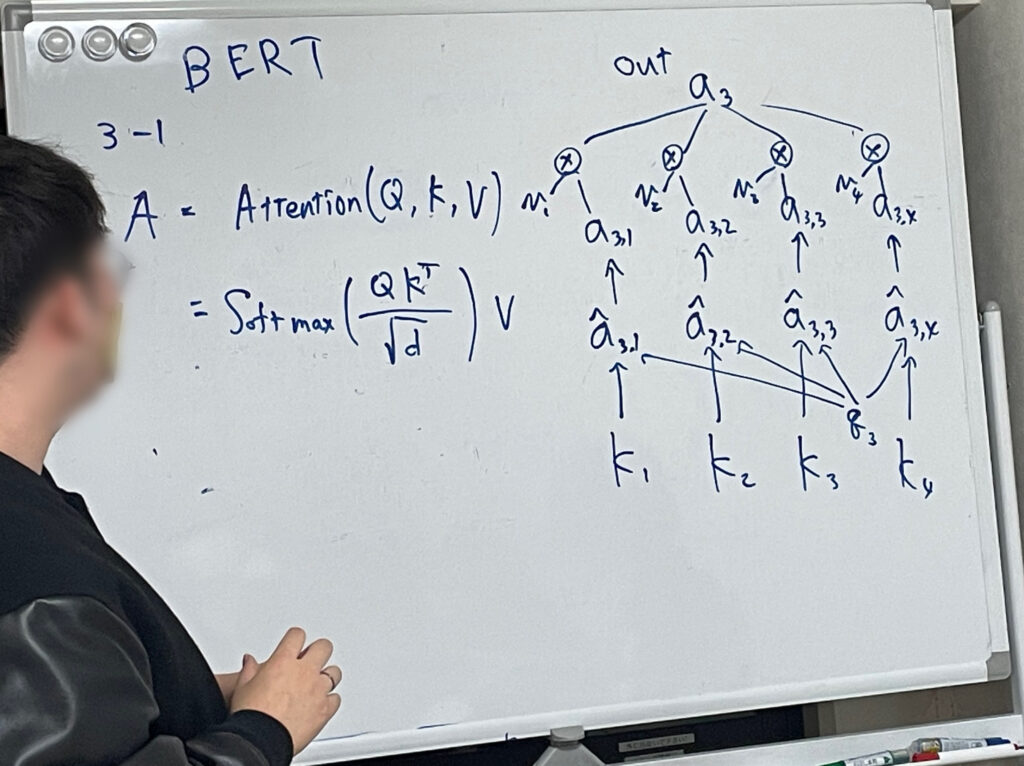

- Attention

BERTは、Attentionという手法を用いています。Attentionでは、文章中のある単語が入力として与えられたとき、別のどの単語に注目するべきかを調べます。これによって離れた位置の情報も適切に取り入れることができ、より深く文脈を捉えられるようになります。 - BERTの使い方

Huggingface社が提供しているライブラリTransformersを使うことで、BERTを利用できます。BERTを用いた処理は、以下の2ステップに分かれています。- トークナイザを用いて、文章をトークン化して、BERTに入力できる形にする

- 上で処理したデータをBERTに入力し、出力を得る(BertModelを使うことで、トークンの分散表現を得ることができる)

第3回 文章の穴埋め、文章分類

2023/11/27に実施。

5章と6章を読み進め、以下の内容を学習しました。

- 文章の穴埋め

文章の穴埋めにはBertForMaskedLMを使います。穴埋めを行うには、文章の一部を特殊トークン[MASK]に置き換えたものを用意します。BertForMaskedLMを用いることで、[MASK]に入るトークンを語彙の中から予測することができます。 - 文章分類

文章分類にはBertForSequenceClassificationを使います。文章分類を行うためにはファインチューニングが必要です。文章分類で、私たちが定めたカテゴリーに分類させるためには、それ用の追加学習が必要となるためです。

第4回 マルチラベル文章分類、固有表現抽出

2023/12/11に実施。

7章と8章前半を読み進め、以下の内容を学習しました。

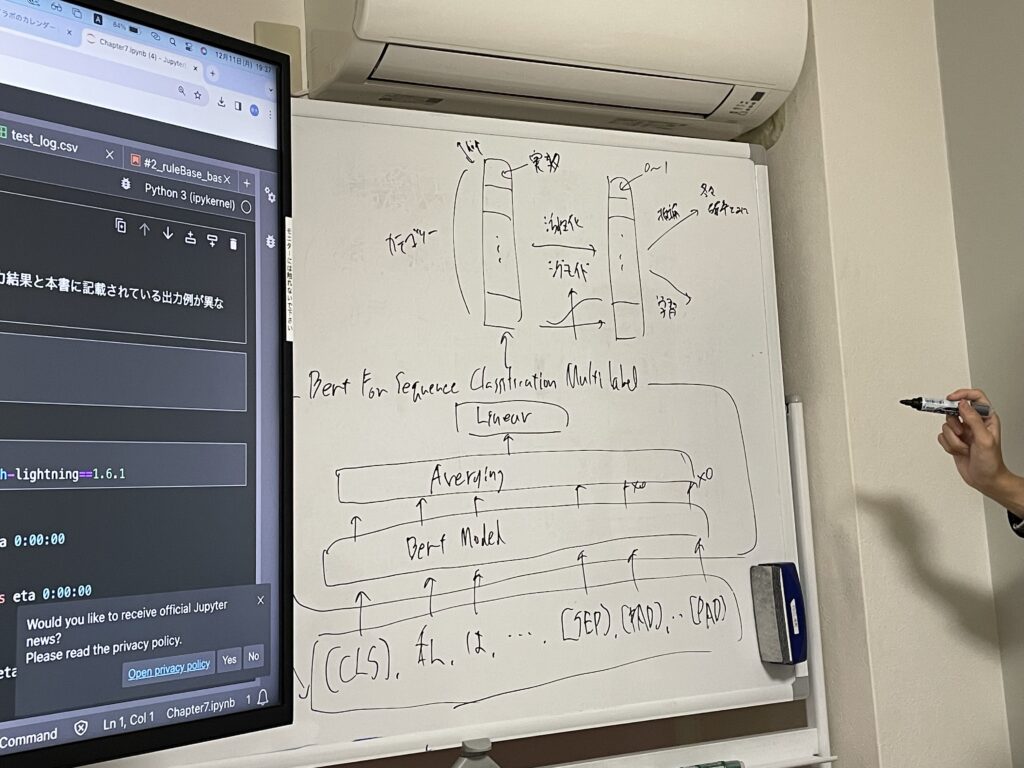

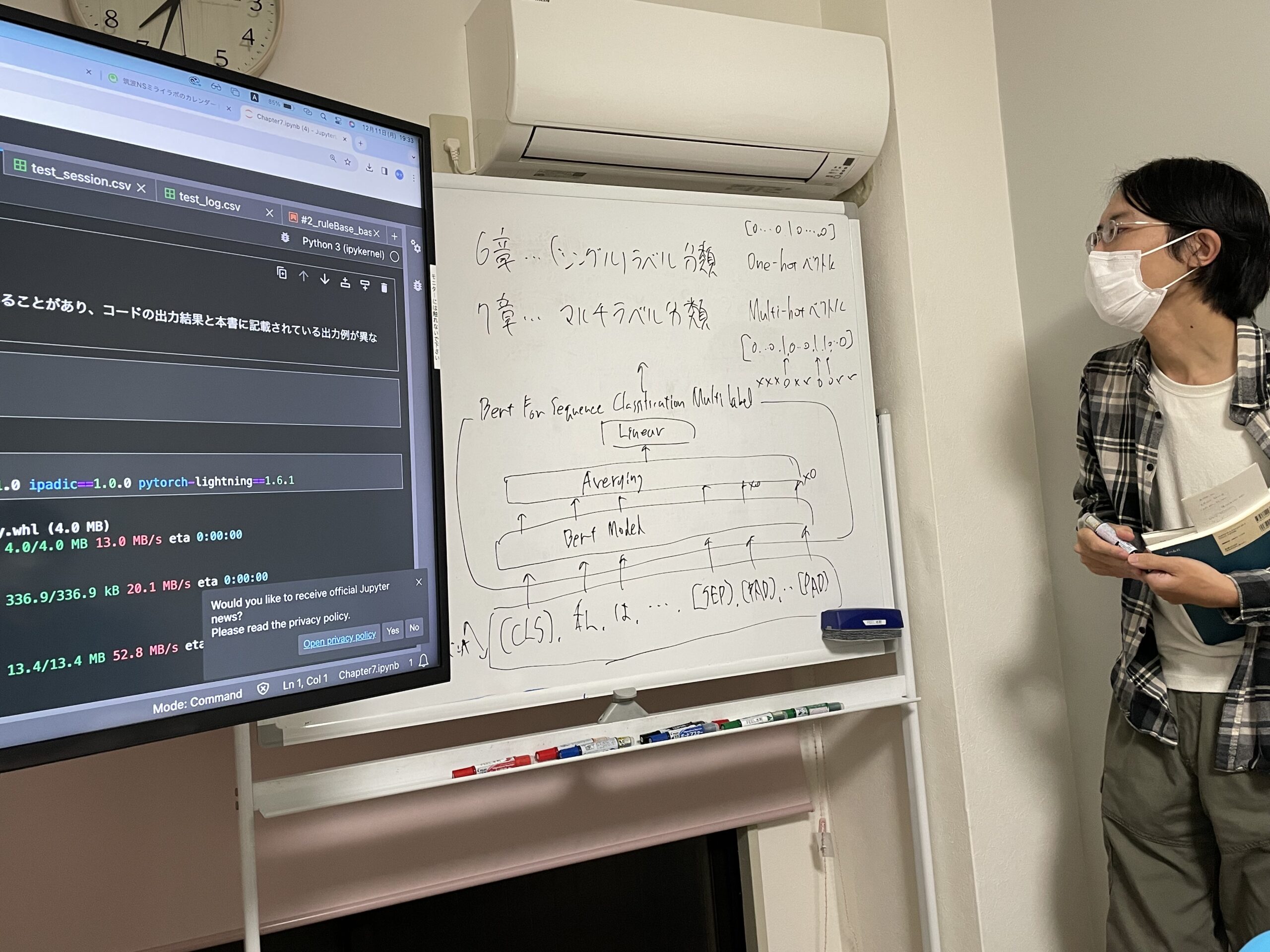

- マルチラベル文章分類

選択肢の中から複数のカテゴリーを選ぶ分類をマルチラベル分類と言います。マルチラベル分類を行うためのモデル BertForSequenceClassificationMultiLabelをPyTorchで実装しました。また、前回の(シングルラベル)分類同様、ファインチューニングもを行いました。 - 固有表現抽出

文章から人名などの固有名詞などを抽出することを固有表現抽出と言います。固有表現抽出を行うには、各トークンにタグをつけます。今回はIO法と呼ばれる方法でタグづけを行いました。

第5回 固有表現抽出、文章校正

2024/01/15に実施。

8章後半と9章を読み進め、以下の内容を学習しました。

- 固有表現抽出(続き)

前回学んだIO法では、同じタイプの固有表現が連続する場合にそれらを連結してしまいます。その問題を解消するために、BIO法と呼ばれる方法でのタグづけを学びました。 - 文章校正

文章校正のタスクは、それぞれのトークンのラベルを予測する分類問題として取り扱えます。ここでは、文章の穴埋めで使ったBertForMaskedLMを使って、文章校正を行いました。

第6回 データの可視化と文章類似検索

2024/02/05に実施。

10章を読み進め、以下の内容を学習しました。

- 文章コーパスの可視化

文章ベクトルがどのように分布しているかを直感的に理解するために、主成分分析やt-SNEによる次元圧縮を行いました。 - 類似文章検索

ベクトルのコサイン類似度を用いて、類似文章検索を行いました。

おわりに

機械学習4冊目の輪読会でした。これまでの本は理論中心でしたので、今回の本でさまざまなタスクに取り組めてよかったです。

さて、次回は強化学習の本を読んでいく予定です。

では、またね!

コメントを書く